Wir bauen unsere Konnektoren zu gängigen Shop-, CRM-, ERP- und anderen Systemen ständig aus. Du findest eine Liste vorgefertigter Schnittstellen hier.

Schnittstelle in Hublify einrichten

Hierzu wechselst du in der Hublify App in den Bereich System / Datahub.

Unter "Connect with..." findest du die vorbereiteteten Konnektoren, die für dein System freigeschaltet sind.

Folge den Anweisungen für das jeweilige System und fülle das vorbereitete Fomular aus.

Für das Feld „POS-Channel“ solltest du einen kurzen sprechenden und eindeutigen Namen festlegen. Dieser findet sich später in allen Konfigurationen wieder, die hier automatisch eingerichtet werden und ihm werden später auch die importierten Aufträge zugewiesen. Dies wird insbesondere dann wichtig, wenn du mehrere Shops anbinden möchtest. Über den POS-Channel kannst du zudem auch (optional) steuern, welche Produkte zu welchem Preis in welchen Shop exportiert werden sollen.

Beim Einrichten der Verbindung wird ein erster kleiner Test der Zugangsdaten durchgeführt und bei Erfolg wird deine Schnittstelle konfiguriert.

Jetzt kannst du in der Hublify-App bereits auf Livedaten zugreifen und könntest deine Auftrags- und Produktdaten synchronisieren.

Im Reiter „Bestehende Verbindungen“ findest du eine Übersicht mit den vorbereiteten Daten und kannst diese bei Bedarf weiter bearbeiten.

Bestehende Verbindungen

Diese Übersicht ist der einfachste Weg, die pro Shop vorhandenen Konfigurationen einzusehen und zu bearbeiten.

Datasets

Hier kannst du direkt in deiner Hublify-App auf Livedaten deines externen Systems zugreifen.

Je nach System können die Daten dort unterschiedlich detailliert angezeigt sein.

Diese Datasets sind die Grundlage für die in Folge konfigurierten Datenabgleiche.

SyncMeta

Der schnelle Überblick zu den bereits synchronisierten Datensätzen.

In den zugehörigen Listen unter "System" / "DataHub" / "Sync Metadaten" kannst du dir weitere Details zu den bereits abgerufenen Daten ansehen.

Achtung: Diese Listen dienen zusätzlich auch als Hilfsmittel, um bereits übertragene Datensätze zu erkennen.

Falls du also im externen System oder in Hublify Daten löscht, solltest du auch hier die zugehörigen Einträge löschen.

Dataset Actions

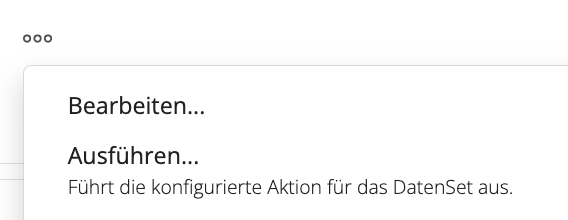

Dies sind die konfigurierten Datenabgleiche zwischen Hublify und deinem Shopify-Shop. Beim Einrichten der Verbindung werden dort typische Im- und Exporte vorbereitet. Diese kannst du passend zu deinem gewünschten Setup anpassen und erweitern. In der Übersicht kannst du die zugehörige Aktion auch direkt über das "..." Menü auslösen oder die Einstellungen bearbeiten.

Das jeweilige Mapping der Quell- und Zieldaten findest du entweder direkt in den Einstellungen derr Dataset Action oder ausgelagert als eigene "Data Map". In diesem Fall findest du das Label der Data Map in den Einstellungen als "dm_label". Zu den jeweils möglichen Einstellungen prüfe bitte auch die speziellen Anleitungen für dieses System bzw. diesen Im/Export.

DaemonJobs

Nachdem du die Dataset Actions (sofern nötig) angepasst hast, wirst du einige davon vermutlich automatisieren wollen.

Du hast natürlich weiter die Möglichkeit, diese auch manuell oder on demand auszuösen.

Um dir eine mögliche Automatisierung zu erleichtern ist aber auch jeweils schon ein inaktiver DaemonJob vorbereitet. Du kannst diesen bei Bedarf aktivieren und anpassen, wie häufig dieser ausgeführt werden soll.

Des weiteren hast du die Möglichkeit, zusätzliche Filter anzugeben, die nur bei der automatischen Ausführung verwendet werden. Diese werden mit den fix in den "iteratorParams" der Dataset Action gesetzten Einstellungen kombiniert.

Best Practise / Tipps

Datenmenge

Wo immer möglich, sollte die Menge der übertragenen Daten auf die wirklich benötigten reduziert werden.

Hierfür prüfst du am besten, welche Filter dir für das jeweilige Quellsystem zur Verfügung stehen.

Meist gibt es die Möglichkeit, nach z.B. dem letzten Änderungszeitpunkt zu filtern. So kannst du nach einem Initialabgleich einstellen, dass nur die Daten exportiert oder importiert werden sollen, die sich tatsächlich verändert haben.

Falls möglich, kannst du auch die "fields" einschränken, die jeweils abgerufen werden.

Frequenz

Während es bei einigen Daten wichtig sein kann, sie möglichst schnell zu erhalten (z.B. neue Aufträge oder geänderte Bestände), ändern sich andere Daten kaum. Wähle die Frequenz deines Datenabgleichs daher passend zu den jeweiligen Daten und ihrer Nutzung im Zielsystem. Und passe den zuvor erwähnten Filter an die Frequenz deines Datenabgleichs an.

Erlaube dabei aber immer auch einen gewissen Puffer.

Initiale Einstellungen / Tests

Prüfe deine Einstellungen am besten mit einer kleinen Datenmenge. Wähle dafür typische Datensätze, die insbesondere deine potentiellen Sonderfälle berücksichtigen und filtere nach diesen, bevor du die Dataset Actions ausführst. So kannst du deine Einstellungen prüfen, ohne gleich riesige Datenmengen zu übertragen.

Mapping

Nutze die Details zu den abgeglichenen Testdaten in SyncMeta, um eventuell noch fehlende Sonderfelder aufzufinden. Du siehst dort üblicherweise neben den bereits gemappten Daten auch die Originaldaten, die abgerufen wurden.

Importe

Kategorien & Produkte

Aktion: "category_pull"

Die Kategorien werden in Hublify als Baumstruktur gespeichert.

Dabei wird für jeden konfigurierten Import ein eigener Katalog angelegt.

Typischerweise ändern sich die Kategorien nicht allzu häufig, so dass man diese oft nur gelegentlich aktualisieren muss.

Da die Kategorien beim Import der Produkte verwendet werden, sollte man immer erst die Kategorien und dann erst die Produkte importieren.

Importierte Datenfelder

Sofern in den Quelldaten verfügbar, werden standardmässig die folgenden Datenfelder importiert.ngr_label - das Label des Katalogsnode_code - ein eindeutiger Code für diese Kategorienode_codefather - der eindeutige Code der übergeordneten Kategorienode_name - der Name der Kategorieactive - Ist diese Kategorie aktiv / sichtbarmeta_title - Titel zur Verwendung in Metadatenmeta_keywords - Keywords zur Verwendung in Metadatenmeta_description - Beschreibung zur Verwendung in Metadatentitle - Überschrift, meist identisch mit dem Namenbody - HTML-Text für z.B. Kategorie-Detailseiten

Produkte und Produktvarianten

Aktion: "product_pull"

In Hublify wird jede Variante als eigenständiges Produkt mit uniquem Produktcode (SKU) erfasst. Über einen Master-Produktcode können diese gruppiert werden.

Standardmäßig werden "Farbe", "Größe" und "Ausführung" als Variantenfelder vorgehalten und gemapped. Weitere Variantenfelder können bei Bedarf konfiguriert werden.

Importierte Datenfelder

Produkten zugewiesene Bilder können beim Import anhand Ihrer URL direkt mit ins Hublify-MAM importiert werden.

Preise können bei Bedarf spezifisch für den beim Import angegebenen POS-Channel importiert werden.

Der vorkonfigurierte Import weist die jeweils verfügbaren Standardfelder des externen Systems bereits den passenden Hublify Produkt-Datenfeldern zu.

Es empfiehlt sich, das zugehörige Mapping zu prüfen, da gerade bei Produktdaten oft noch weitere individuell konfigurierte Attribute vorhanden sein könnten. Diese können im pro Import hinterlegten Mapping ergänzt/angepasst werden

Auswahl der häufig bereits im Mapping vorkonfigurierten Produkt-Datenfelder:pcode - Produktcode / SKUmaster_pcode - Varianten-Mastercodename - Produkt Namedescription - Beschreibungdesc_short - Kurzbeschreibungmanufacturer - Herstellerpcode_manufacturer - Hersteller-Produktcodegtin - GTIN / EANprdv_color - Varianten-Farbeprdv_size - Varianten-Größeprdv_other - Varianten-Ausführungpack_amount - Verpackungsmengepack_unit - Verpackungseinheitmeta_title - Titel zur Verwendung in Metadatenmeta_keywords - Keywords zur Verwendung in Metadatenmeta_description - Beschreibung zur Verwendung in Metadatenvat - MwSt-Satzprd_delivery - Lieferhinweisprd_storage_counter - Lagerbestandavailable_date - verfügbar abprice - Standard-Bruttopreisdiscount - Discount-Bruttopreisstate - Online-Status (2 = online, 1 = offline)order_quanti_max - Maximale Bestellmengeorder_quanti_min - Minimale Bestellmengeorder_quanti_inc - Bestellmengen Schrittweite

Kunden & Aufträge

Aktion: "person_pull"

Kundendaten und sofern verfügbar gespeicherte Adressen können in Hublify übernommen werden.

Spezielle Kundengruppen können im zugehörigen Mapping zugeordnet oder auch grundsätzlich hinterlegt werden.

Um sicherzustellen, dass jeder Kunde eine eindeutige Kundennr. bekommt, wird von Haus aus eine eigene Kundennr. in Hublify vergeben. Die Kundennr. des externen Systems wird als "externe Kundennr." übernommen, ggf. mit einem Prefix passend zum gewählten Import. Dies kann im Mapping angepasst werden.

Importierte Datenfelder

Auswahl typischerweise importierter Kunden-Datenfelder

p_personid_external - externe Kundennr.gender - Anredefirstname - Vornamelastname - Nachnameemail - E-Mailcompany - Firmataxident - UstId.street - Straßehousenr - Hausnummeraddress2 - Adresszusatzzip - Postleitzahltown - Ortcountry - Land (ISO-Code)telephone - Telefontelefax - Fax

Aufträge

Aktion: "order_pull"

Beim Import von Aufträgen können Versandarten, Zahlungsarten und Kampagnen automatisch mit angelegt werden.

Noch nicht vorhandene Kundendatensätze werden automatisch angelegt. Daher ist es wichtig, dass die Mapping-Einstellungen für diese beim Kunden- und Auftragsimport gleich vergeben werden.

Achtung: Importierte Aufträge werden wie frisch eingegangene Bestellungen gewertet. Daher wird für bestellte Produkte mit einem hinterlegten Lagerbestand dieser beim Import der Aufträge passend zu den bestellten Mengen heruntergezählt.

Für den Fall, dass historische Aufträge importiert werden, sollte der Lagerbestand anschließend noch einmal aktualisiert werden.

Exporte

Für Exporte aus Hublify heraus, kannst du die gleichen Filter/Fields-Einstellungen verwenden, die auch bei der Nutzung über die Web-API gelten. Zusätzlich hast du in den jeweiligen Aktions-Menüs der Daten auch die Möglichkeit, gezielt für einzelne Datensätze (oder mehrere markierte) den Export auszulösen.

Hierbei werden die fix in den Dataset Actions hinterlegten Filter mit dem Filter auf den jeweiligen Datensatz kombiniert. Falls du also zum nur Produkte aus einer bestimmten Kategorie exportieren möchtest und dies als Filter in der Dataset Action hinterlegt hast, würde die Übertragung nur für die gewählten Produkte ausgeführt werden, die dieser Kategorie zugewiesen sind.

Kategorien & Produkte

Da die Kategorien in den Produktdaten verwendet werden, sollte immer zuerst der entsprechende Kategoriebaum einmal komplett übertragen werden. Da sich die Kategorien tendenziell nicht ganz so häufig ändern, müssen diese anschließend oft nur noch on demand aktualisiert werden, wenn hieran Änderungen vorgenommen wurden.

Je nach System kann nötig sein, alle Varianten eines Produktes zusammen zu übertragen. In diesen Fällen ist in den iteratorParams der Export-Aktion der Parameter "groupByVariant" eingetragen. Dieses bitte nicht ändern, da es für den entsprechenden Export benötigt wird.

Falls mehrere externe Systeme angeschlossen werden sollten, können die Preise / Online-Status pro externem Channel eingestellt werden. In diesem Fall wird ein Filter auf den POS-Channel mit benötigt.

Kunden & Aufträge

Bitte beachte, dass Aufträge nicht gesamtheitlich an externe Systeme übertragen werden. Es besteht aber die Möglichkeit, bestimmte Statusinformationen zurück in das System zu übertragen, aus dem der Auftrag ursprünglich importiert wurde.

Kundeninformationen können an externe Systeme übertragen werden. Dies kann z.B. bei einem Systemwechsel sinnvoll sein. Im laufenden Betrieb solltest du aber beachten, welches System die führenden Daten enthält. Übertrage daher nur die Daten, die der Kunde nicht selbst auf dem externen System geändert haben kann.